La sagesse conventionnelle dit : « Si vous ne voulez pas que vos données soient utilisées, retirez-vous de tout ».

Nous disons : « Si vos données sont collectées de toute façon, il est plus rationnel d'influencer la manière dont elles sont utilisées ».

Ce n'est pas : « Les entreprises devraient-elles avoir accès à mes données ? » (Elles y ont déjà accès).

La vraie question est : « Mes données devraient-elles contribuer à améliorer l'IA pour tous ? »

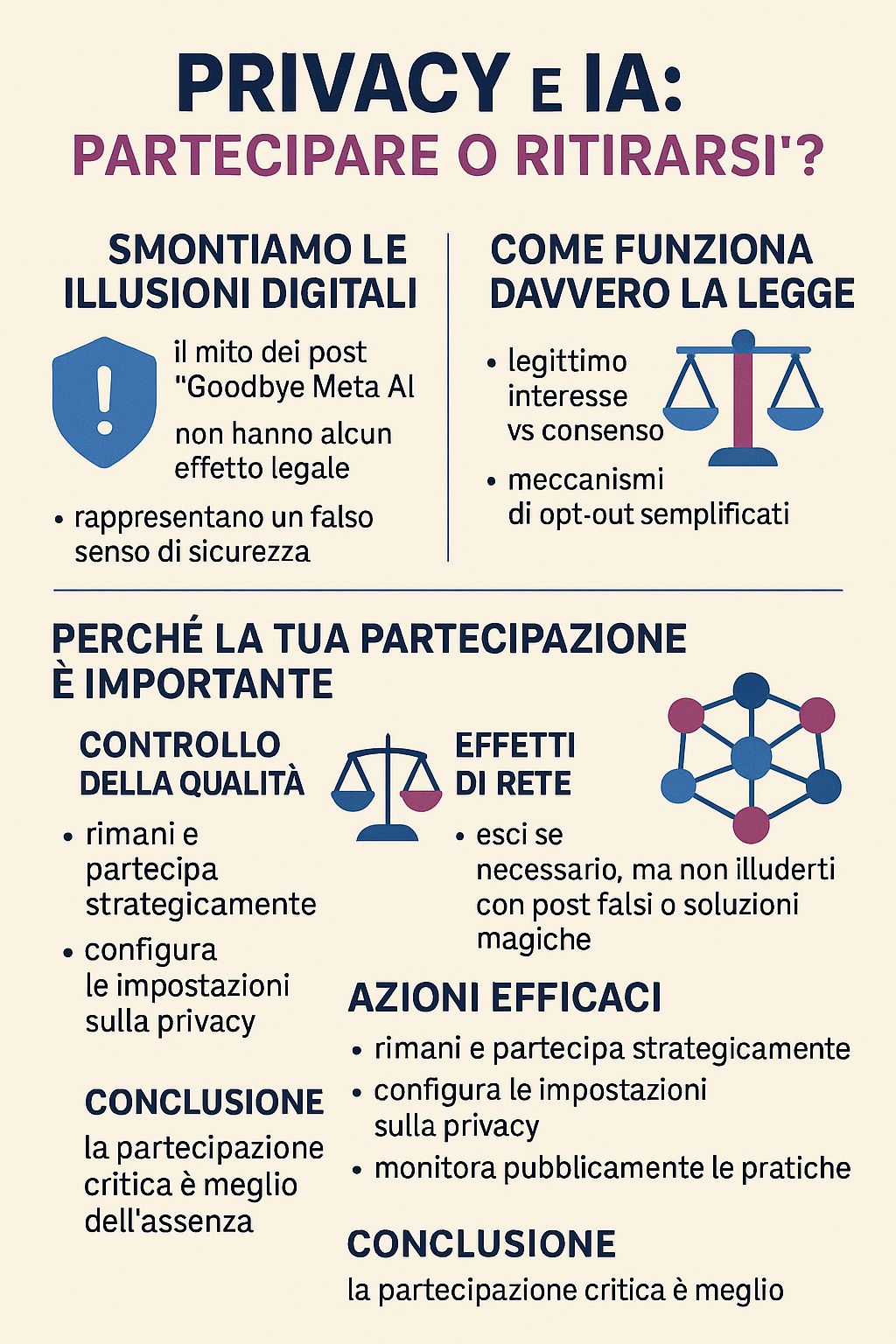

Avant de construire un argumentaire sérieux, il est essentiel de démystifier une dangereuse illusion qui circule sur les réseaux sociaux : les publications virales « Goodbye Meta AI » qui promettent de protéger vos données simplement en partageant un message.

La vérité dérangeante : ces publications sont complètement fausses et peuvent vous rendre plus vulnérable.

Comme l'explique Meta elle-même, « partager le message « Goodbye Meta AI » ne constitue pas une forme valable d'opposition ». Ces publications :

Le succès viral de ces publications révèle un problème plus profond : nous préférons les solutions simples et illusoires aux décisions complexes et éclairées. Partager une publication nous donne le sentiment d'être actifs sans avoir à faire l'effort de comprendre réellement comment fonctionnent nos droits numériques.

Mais la vie privée ne se défend pas avec des mèmes. Elle se défend avec la connaissance et l'action consciente.

Depuis le 31 mai 2025, Meta a mis en place un nouveau régime pour la formation de l'IA en utilisant comme base juridique l'« intérêt légitime » plutôt que le consentement. Il ne s'agit pas d'une échappatoire, mais d'un outil juridique prévu par le RGPD.

L'intérêt légitime permet aux entreprises de traiter des données sans consentement explicite si elles peuvent démontrer que leur intérêt ne prévaut pas sur les droits de l'utilisateur. Cela crée une zone grise où les entreprises « adaptent la loi sur mesure » grâce à des évaluations internes.

L'utilisation de données non anonymisées comporte « des risques élevés d'inversion du modèle, de fuites de mémorisation et de vulnérabilités d'extraction ». La puissance de calcul nécessaire signifie que seuls les acteurs disposant d'une capacité très élevée peuvent exploiter efficacement ces données, créant ainsi des asymétries systémiques entre les citoyens et les grandes entreprises.

Maintenant que nous avons clarifié la réalité juridique et technique, construisons l'argumentaire en faveur d'une participation stratégique.

Lorsque les personnes conscientes abandonnent, l'IA s'entraîne sur celles qui restent. Voulez-vous que les systèmes d'IA s'appuient principalement sur les données de personnes qui :

Les préjugés dans l'IA surviennent lorsque les données d'entraînement ne sont pas représentatives. Votre participation contribue à garantir :

Les systèmes d'IA s'améliorent avec l'échelle et la diversité :

Si vous utilisez des fonctionnalités basées sur l'IA (recherche, traduction, recommandations, outils d'accessibilité), votre participation contribue à les améliorer pour tous, y compris les futurs utilisateurs qui en ont le plus besoin.

Votre vie privée ne change pas de manière significative entre l'opt-in et l'opt-out pour l'IA. Les mêmes données alimentent déjà :

La différence réside dans le fait que ces données contribuent également à améliorer l'IA pour tous ou qu'elles servent uniquement les intérêts commerciaux immédiats de la plateforme.

C'est exactement pour cette raison que des personnes responsables comme vous devraient participer. Se retirer n'arrête pas le développement de l'IA, cela ne fait que supprimer votre voix.

Les systèmes d'IA seront développés quoi qu'il arrive. La question est : avec ou sans la contribution de personnes qui réfléchissent de manière critique à ces questions ?

C'est compréhensible. Mais réfléchissez à ceci : préférez-vous que les systèmes d'IA soient conçus avec ou sans la contribution de personnes qui partagent votre scepticisme envers les grandes entreprises ?

Votre méfiance est précisément la raison pour laquelle votre participation critique est précieuse.

L'intelligence artificielle devient une réalité, que vous y participiez ou non.

Votre choix n'est pas de savoir si l'IA sera développée, mais si l'IA qui sera développée reflétera les valeurs et les perspectives des personnes qui réfléchissent attentivement à ces questions.

Se désinscrire, c'est comme ne pas voter. Cela n'empêche pas les élections, cela signifie simplement que le résultat ne tiendra pas compte de votre contribution.

Dans un monde où seuls les acteurs disposant d'une puissance de calcul très élevée peuvent interpréter et exploiter efficacement ces données, votre voix critique dans la formation peut avoir plus d'impact que votre absence.

Restez et participez stratégiquement si :

Et en attendant :

Mais ne te fais pas d'illusions avec :

Votre renonciation individuelle a un impact minime sur votre vie privée, mais rester a un impact réel sur tout le monde.

Dans un monde où les systèmes d'IA détermineront le flux d'informations, les décisions et les interactions entre les personnes et la technologie, la question n'est pas de savoir si ces systèmes doivent exister, mais s'ils doivent inclure le point de vue de personnes réfléchies et critiques comme vous.

Parfois, l'action la plus radicale n'est pas de renoncer. Souvent, la manière la plus radicale est de rester et de s'assurer que sa voix soit entendue.

Anonyme

Il ne s'agit pas de faire aveuglément confiance aux entreprises ou d'ignorer les préoccupations liées à la confidentialité. Il s'agit de reconnaître que la confidentialité ne se défend pas avec des mèmes, mais avec une participation stratégique et consciente.

Dans un écosystème où les asymétries de pouvoir sont énormes, votre voix critique dans la formation de l'IA peut avoir plus d'impact que votre absence protestataire.

Quel que soit ton choix, fais-le en toute connaissance de cause, sans te laisser bercer par des illusions numériques.

Un paragraphe de sympathie également pour les « ermites de la vie privée » - ces âmes pures qui croient pouvoir échapper complètement au traçage numérique en vivant hors ligne comme des moines tibétains de 2025.

Spoiler : même si vous allez vivre dans un chalet isolé dans les Dolomites, vos données sont déjà partout. Votre médecin traitant utilise des systèmes numériques. La banque où vous conservez vos économies pour acheter du bois de chauffage enregistre chaque transaction. Le supermarché du village dispose de caméras et de systèmes de paiement électronique. Même le facteur qui vous apporte vos factures contribue à des ensembles de données logistiques qui alimentent des algorithmes d'optimisation.

En 2025, se retirer totalement du monde numérique revient essentiellement à s'exclure de la société civile. Vous pouvez renoncer à Instagram, mais vous ne pouvez pas renoncer au système de santé, bancaire, éducatif ou professionnel sans conséquences dramatiques sur votre qualité de vie.

Et pendant que vous construisez votre cabane anti-5G, vos données continuent d'exister dans les bases de données des hôpitaux, des banques, des assurances, des municipalités, des agences fiscales, et sont toujours utilisées pour former des systèmes qui influenceront les générations futures.

Le paradoxe de l'ermite : votre isolement protestataire n'empêche pas les systèmes d'IA d'être entraînés à partir des données de personnes moins conscientes, mais il vous exclut de la possibilité d'influencer leur développement dans des directions plus éthiques.

En substance, vous avez conquis la pureté morale immaculée de ceux qui observent l'histoire depuis les gradins, tandis que d'autres, moins éclairés mais plus présents, écrivent les règles du jeu.

Quel que soit ton choix, fais-le en toute connaissance de cause, sans te laisser bercer par des illusions numériques.

Articles cités :

Approfondissements RGPD et intérêt légitime :

Ressources officielles :

Pour des actions concrètes : si vous êtes en Europe, vérifiez les procédures officielles de désinscription auprès de l'autorité chargée de la protection des données. Pour des informations générales, consultez les paramètres de confidentialité et les conditions d'utilisation de votre plateforme. Et n'oubliez pas : aucune publication sur les réseaux sociaux n'a de valeur juridique.