Dans le monde des affaires, de nombreuses décisions reposent encore sur l'instinct ou sur des tests lents qui modifient une variable à la fois. La conception d'expérience (DOE) est une approche statistique structurée qui renverse ce paradigme. Elle vous permet de tester plusieurs facteurs simultanément afin de découvrir efficacement quelles combinaisons donnent les meilleurs résultats, ce qui vous fait gagner énormément de temps et de ressources. Dans ce guide, vous apprendrez à utiliser la conception d'expérience pour transformer vos doutes en décisions fondées sur des preuves concrètes, en optimisant vos processus et vos campagnes grâce à une méthode scientifique enfin accessible à tous.

Imaginez que vous souhaitiez perfectionner la recette d'un gâteau. L'approche traditionnelle, connue sous le nom de « one-factor-at-a-time » (OFAT), consisterait à tester d'abord différentes quantités de farine, en gardant tous les autres ingrédients fixes. Une fois la « bonne » dose trouvée, vous passeriez au test du sucre, et ainsi de suite. Un processus long et, franchement, peu efficace.

En effet, cette méthode est non seulement lente, mais elle ignore également un élément crucial : les interactions. La quantité optimale de sucre dépend peut-être du type de farine utilisé. L'approche OFAT ne permettra jamais de découvrir cette synergie, laissant ainsi de côté une amélioration potentielle décisive.

C'est là qu'intervient la conception d'expérience. Au lieu d'isoler les variables, la DOE vous guide pour les faire varier simultanément, mais de manière planifiée et intelligente. Une méthode non seulement plus rapide, mais qui vous permet enfin de voir comment les différents facteurs s'influencent mutuellement.

La véritable valeur de la conception d'expérience ne réside pas seulement dans la compréhension des facteurs importants, mais aussi dans la découverte de la manière dont ils interagissent pour obtenir le meilleur résultat possible.

Cette approche structurée transforme le processus décisionnel, qui passe d'un jeu d'intuitions à une science fondée sur les données. Il s'agit d'un changement de mentalité fondamental, qui permet aux PME d'innover plus rapidement et avec plus de confiance.

Que vous optimisiez une campagne marketing, amélioriez un processus de production ou développiez un nouveau produit, les principes du DOE sont universels. Nous examinerons les concepts statistiques fondamentaux expliqués de manière simple et analyserons les différents types de plans d'expériences afin de vous aider à choisir celui qui vous convient. Nous explorerons également comment les plateformes alimentées par l'IA, telles Electe, une plateforme d'analyse de données pour les PME, rendent ce processus accessible à tous, en automatisant l'analyse et en visualisant clairement les informations. Si vous souhaitez en savoir plus sur la manière dont l'analyse de grandes quantités de données transforme les entreprises, vous pouvez consulter notre article sur l'analyse des mégadonnées.

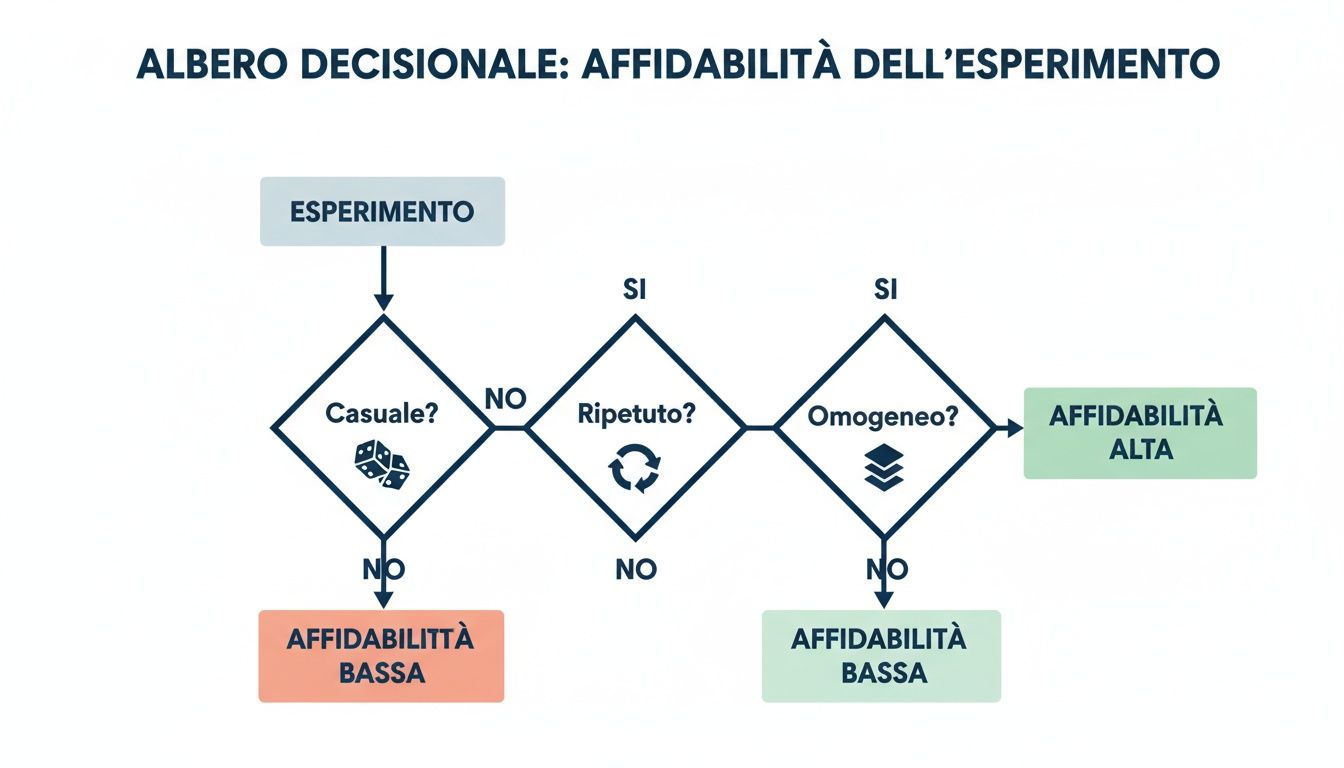

Pour construire un bâtiment solide, vous avez besoin de fondations solides. Le même principe s'applique à la conception d'expériences: si vous voulez obtenir des résultats fiables, votre approche doit reposer sur trois piliers statistiques fondamentaux.

Ne pensez pas à des formules complexes. Il s'agit en réalité de concepts logiques qui garantissent que les conclusions tirées de vos données sont exactes et ne sont pas le fruit du hasard. Comprendre ces trois piliers — randomisation, réplication et blocage — est la première étape pour transformer n'importe quel test en une expérience puissante et crédible.

Le premier pilier est la randomisation. Imaginez que vous souhaitiez tester deux versions différentes d'une publicité. Si vous diffusez la version A uniquement le matin et la version B uniquement l'après-midi, comment savoir si les résultats dépendent de la publicité ou de l'heure ?

La randomisation résout précisément ce problème. En termes simples, cela signifie attribuer de manière aléatoire les différentes « recettes » expérimentales (les versions A et B) aux unités sur lesquelles vous effectuez le test (les utilisateurs). Cela garantit que tous les facteurs que vous ne pouvez pas contrôler, tels que l'heure de la journée ou l'appareil utilisé par l'utilisateur, sont répartis de manière égale entre les groupes. De cette façon, toute différence significative dans les résultats pourra être attribuée avec beaucoup plus de certitude aux facteurs que vous testez.

Le deuxième pilier est la reproduction. Obtenir un résultat une seule fois ne suffit pas. Il pourrait s'agir d'une simple coïncidence. Reproduire une expérience signifie la répéter plusieurs fois dans les mêmes conditions. Chaque répétition est une occasion supplémentaire de vérifier si le résultat observé est cohérent ou s'il s'agit d'un cas isolé.

La réplication est votre assurance contre le hasard. Elle vous aide à comprendre si un effet est réel et reproductible ou s'il s'agit simplement d'un « bruit statistique ».

Prenons l'exemple d'une expérience dans laquelle vous testez une nouvelle mise en page afin d'augmenter le nombre d'inscriptions. Si la nouvelle mise en page remporte l'adhésion d'un seul utilisateur, cela ne signifie rien. En revanche, si elle remporte l'adhésion de 100 utilisateurs sur 120, vous disposez alors d'une preuve beaucoup plus solide. Plus vous disposez de réplications, plus vous pouvez avoir confiance en vos conclusions.

Le troisième pilier est le blocage (blocking). Cette technique vous permet de gérer les sources de variabilité que vous connaissez mais que vous ne pouvez pas éliminer. Imaginez que vous souhaitiez tester l'efficacité de deux méthodes de formation sur deux groupes d'employés : les débutants et les experts. L'expérience antérieure influencera certainement les résultats.

Au lieu de tout mélanger, vous pouvez utiliser le bloc :

Ce faisant, vous comparez « des pommes avec des pommes ». L'effet de la formation est mesuré au sein de groupes homogènes, ce qui neutralise l'impact de la variabilité due à l'expérience. Il est ainsi plus facile de détecter les différences réelles causées par les méthodes de formation elles-mêmes. Des plans expérimentaux bien structurés peuvent réduire le nombre de tests nécessaires jusqu'à 75 % par rapport aux approches traditionnelles, tout en améliorant la précision des résultats. Pour en savoir plus, vous pouvez approfondir ces techniques en détail dans la section Conception d'expériences.

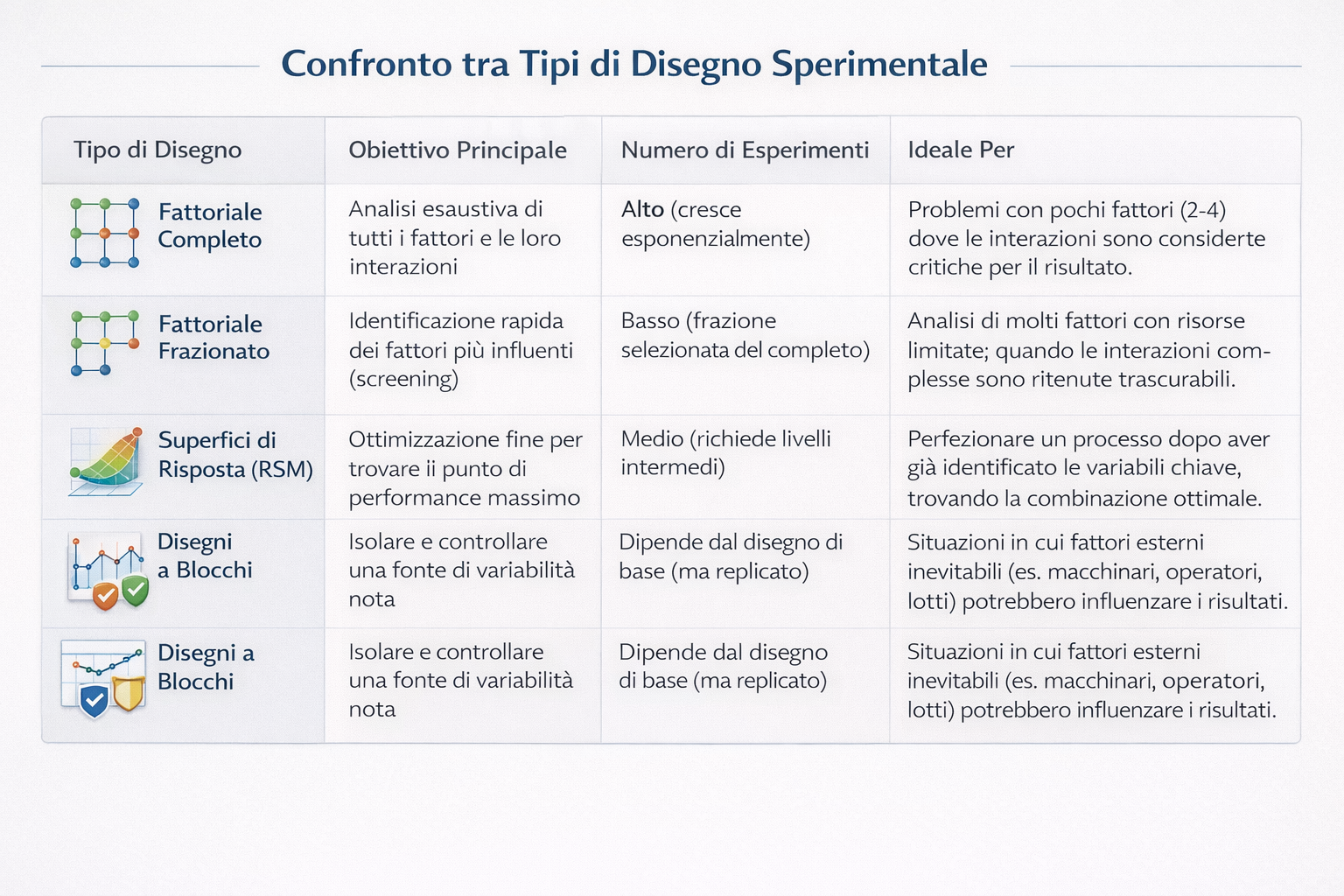

Une fois les principes statistiques compris, l'étape suivante dans la conception d'expérience consiste à choisir la bonne stratégie. Il n'existe pas de recette universelle. Le choix du plan d'expérience dépend de vos objectifs, des ressources disponibles et du nombre de variables que vous souhaitez analyser.

Choisir la bonne méthode revient à choisir le bon outil : utiliser un plan expérimental inadapté peut vous faire perdre du temps et de l'argent, voire vous conduire à prendre des décisions basées sur des conclusions erronées.

Le plan factoriel complet est l'approche la plus rigoureuse. Avec cette méthode, vous testez chaque combinaison possible des niveaux de tous les facteurs que vous étudiez. C'est le choix idéal lorsque vous souhaitez obtenir une compréhension totale du système, y compris toutes les interactions possibles entre les variables.

Imaginez que vous souhaitiez optimiser une page d'accueil avec deux titres (A, B), deux images (1, 2) et deux appels à l'action (X, Y). Un plan factoriel complet nécessiterait 2x2x2 = 8 tests différents pour couvrir toutes les combinaisons (A1X, A1Y, A2X, A2Y, B1X, B1Y, B2X, B2Y).

Lorsque vous avez de nombreux facteurs à analyser, un plan complet devient une véritable gageure. C'est là qu'interviennent les plans factoriels fractionnés, une solution ingénieuse qui vous permet de ne tester qu'une fraction intelligente des combinaisons totales.

L'idée de base est que les interactions plus complexes (entre trois facteurs ou plus) sont presque toujours négligeables. En vous concentrant sur les effets principaux et les interactions à deux, vous pouvez obtenir80 % des réponses avec 20 % d'effort.

Une conception fractionnée est un compromis stratégique entre la profondeur de l'analyse et les ressources. Elle est parfaite pour une première phase de « sélection », afin de comprendre immédiatement quels sont les leviers qui comptent vraiment.

Par exemple, avec 6 facteurs à 2 niveaux chacun, un test complet nécessiterait 64 expériences. Un plan fractionné pourrait vous fournir des indications très fiables avec seulement 16 ou 8 tests.

Ce schéma décisionnel simplifié montre comment les principes de hasard, de répétition et d'homogénéité (obtenue grâce aux blocs) constituent les fondements de la fiabilité de toute expérience. Ce n'est qu'en respectant ces trois piliers que vous pouvez être sûr que vos résultats sont solides.

Une fois les facteurs les plus importants identifiés, votre objectif change. Vous ne voulez plus seulement savoir ce qui fonctionne, mais trouver la combinaison exacte qui maximise un résultat. C'est le moment d'utiliser la méthodologie des surfaces de réponse (RSM).

Considérez le RSM comme la création d'une carte topographique de votre problème. Au lieu de tester uniquement les extrêmes, le RSM explore également les points intermédiaires afin de construire une « surface » qui montre comment la réponse change en fonction des variations des facteurs. L'objectif ? Trouver le « sommet de la montagne », le point de performance optimal.

Enfin, les dessins en blocs sont une stratégie qui s'applique aux méthodes précédentes lorsque vous devez gérer une source de variabilité que vous connaissez, mais que vous ne pouvez pas éliminer. Si, par exemple, vous devez effectuer vos tests sur deux machines différentes, vous savez déjà que cela introduira du « bruit ».

La solution consiste à créer un « bloc » pour chaque machine. À l'intérieur de chaque bloc, réalisez une version de votre expérience. De cette manière, l'effet de la machine est isolé et ne se confond pas avec l'effet des facteurs qui vous intéressent réellement.

Comparaison entre les principaux plans expérimentaux

Ce tableau vous aide à choisir l'approche la mieux adaptée à votre objectif.

La théorie est utile, mais sa véritable puissance se révèle lorsqu'elle se traduit en résultats commerciaux concrets. La conception d'expérience n'est pas un concept abstrait ; c'est un outil stratégique que les entreprises les plus innovantes utilisent pour prendre de meilleures décisions et accélérer leur croissance.

Voyons à l'aide d'exemples concrets comment cette approche transforme des problèmes commerciaux complexes en opportunités mesurables.

Imaginez une entreprise de commerce électronique qui souhaite maximiser le retour sur investissement (ROI) de ses campagnes. Les variables sont nombreuses et les tester une par une serait un processus sans fin.

C'est là que le DOE entre en jeu. L'équipe décide d'utiliser un plan factoriel pour analyser simultanément trois facteurs clés :

Cela crée 2x2x2 = 8 combinaisons à tester. Après avoir lancé l'expérience, l'entreprise utilise une plateforme d'analyse de données pour analyser les données sur les conversions. L'analyse révèle une information qu'un test A/B normal n'aurait jamais pu mettre en évidence.

La remise de 20 %, associée au message « Livraison gratuite », génère un retour sur investissement supérieur de 45 % lorsque la campagne est diffusée sur les réseaux sociaux. La même combinaison ne produit toutefois qu'une augmentation de 5 % par e-mail.

Cette information permet au commerce électronique de réaffecter son budget publicitaire avec précision, en concentrant la formule la plus puissante sur le canal le plus réceptif, avec une augmentation immédiate du retour sur investissement. Cette stratégie est similaire à celle que nous avons mise en œuvre pour optimiser les processus commerciaux de BoxMedia, ce qui prouve que les données peuvent guider des décisions plus intelligentes.

Passons au secteur financier. Une société de prêt souhaite améliorer la précision de son modèle de notation de crédit afin de réduire le taux d'insolvabilité. Moins de risques, plus de profits.

L'équipe d'analystes utilise la conception d'expérience pour comprendre quelles variables des demandeurs ont le plus d'influence sur la probabilité de défaut. Trois variables clés à tester sont identifiées :

Les données sont traitées via leur plateforme d'analyse de données. Les résultats sont révélateurs :l'ancienneté professionnelle a un effet beaucoup plus marqué sur le risque de défaut de paiement chez les clients à faibles revenus, une interaction que le modèle précédent sous-estimait.

Cette découverte permet à l'entreprise de recalibrer son algorithme de notation, avec une réduction estimée à 15 % des défauts de paiement au cours des six mois suivants.

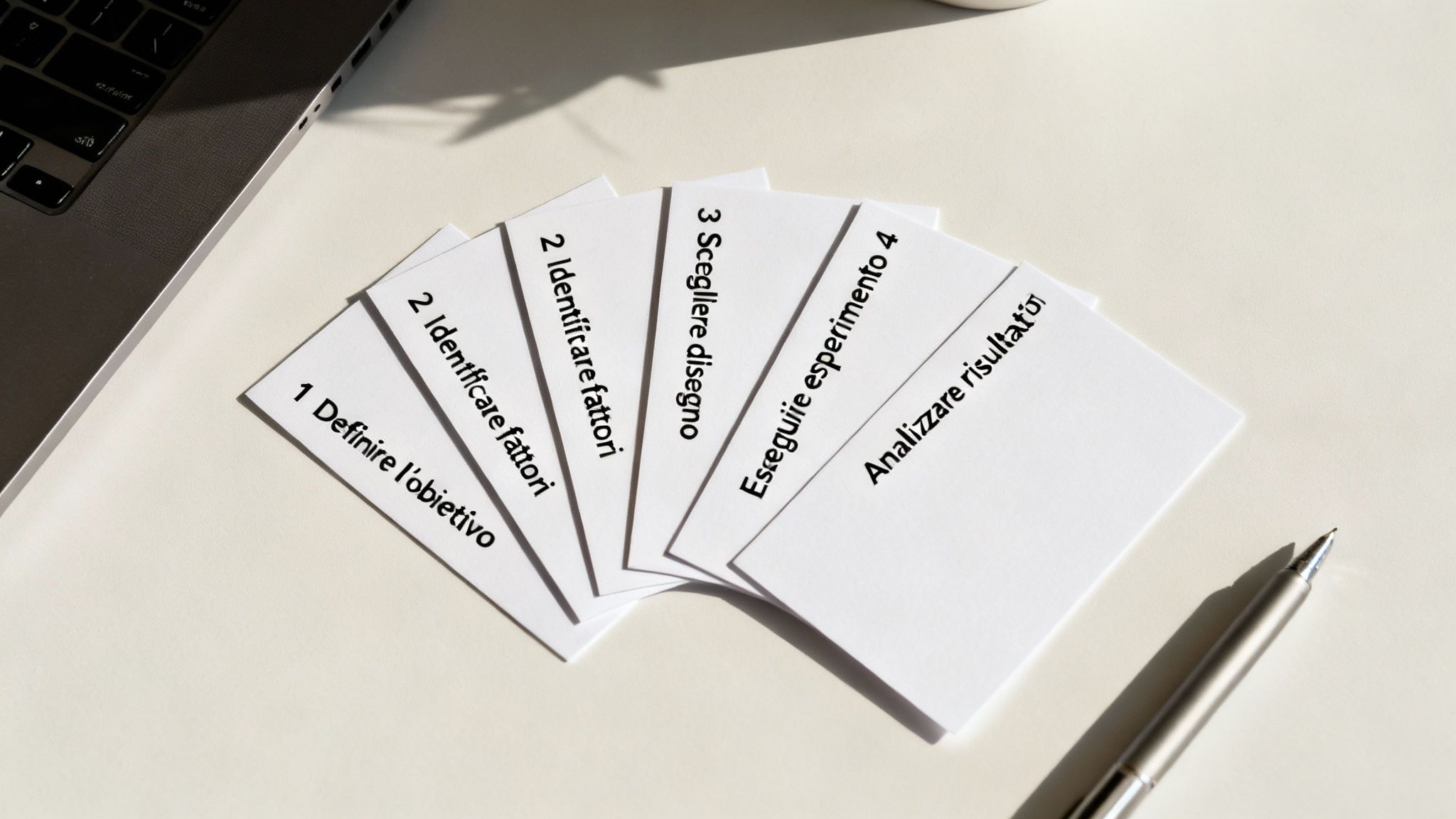

Il est temps de passer à l'action. Concevoir une expérience peut sembler difficile, mais si vous la décomposez en étapes logiques, cela devient un processus gérable et puissant. Ce guide pratique vous accompagnera dans la création de votre première conception d'expérience.

Tout commence par une question spécifique. « Je veux augmenter les ventes » est un souhait, pas un objectif. Il faut quelque chose de mesurable. Demandez-vous : que veux-je améliorer exactement? Et comment vais-je mesurer le succès ?

Maintenant que vous avez défini votre objectif, vous devez déterminer les leviers sur lesquels vous pouvez agir. Il s'agit des facteurs, c'est-à-dire des variables que vous pouvez contrôler. Pour chaque facteur, définissez les niveaux, c'est-à-dire les valeurs spécifiques que vous souhaitez tester.

Pour l'objectif précédent, les facteurs pourraient être les suivants :

Une erreur courante consiste à vouloir tout tester immédiatement. Commencez par quelques niveaux pour chaque facteur (deux ou trois sont idéaux) afin que l'expérience reste gérable.

C'est à ce stade que vous décidez de la « recette » de votre expérience.

Nous sommes à une étape cruciale. Ici, la précision est primordiale. Les données doivent être collectées de manière claire et cohérente. Rappelez-vous les principes clés : utilisez la randomisation pour répartir équitablement toute influence externe. Si les ressources le permettent, effectuez des réplications pour vous assurer que les résultats ne sont pas le fruit du hasard.

Vous disposez de vos données. Et maintenant ? L'analyse sert à comprendre quels facteurs ont eu un impact significatif, quelles interactions sont apparues et quelle est la combinaison gagnante. C'est là qu'une plateforme telle que Electe peut faire la différence. Au lieu de vous perdre dans des analyses complexes, vous pouvez télécharger vos données et laisser l'intelligence artificielle faire le gros du travail, en transformant les données brutes en graphiques intuitifs et en informations prêtes à l'emploi. Cette approche est de plus en plus reconnue : vous pouvez explorer les statistiques expérimentales de l'Istat pour voir comment elle est appliquée au niveau national.

Concevoir une expérience n'est que la moitié du travail. L'autre moitié, souvent la plus délicate, consiste à analyser les données collectées afin d'obtenir des informations utiles pour l'entreprise. C'est là que de nombreuses entreprises échouent, bloquées par la nécessité d'utiliser des logiciels statistiques complexes.

Electe, notre plateforme d'analyse de données alimentée par l'IA, résout ce problème. Au lieu de vous faire perdre des heures en calculs, la plateforme se connecte à vos sources de données et automatise l'ensemble du processus d'analyse.

Notre objectif est clair : nous voulons faire du Design of Experiments un outil démocratique, une arme stratégique que chaque manager peut utiliser pour prendre de meilleures décisions basées sur des preuves concrètes.

En un seul clic, la plateforme Electe des analyses statistiques avancées telles que l'ANOVA (analyse de variance) et vous fournit les résultats sous forme de tableaux de bord interactifs et faciles à lire. Cela vous permet de :

Electe le pont qui relie les données brutes de votre expérience aux informations stratégiques qui guident la croissance. Nous nous occupons de la complexité de l'analyse afin que vous puissiez vous concentrer sur votre activité.

La validité de cette approche est également reconnue dans le milieu universitaire : des cours de « conception d'expériences » sont proposés dans le cadre de cursus universitaires, comme celui de l'université de Bologne. Si le sujet vous intéresse, vous pouvez en savoir plus sur le programme universitaire. Grâce à un logiciel d'analyse commerciale optimisé par l'IA, vous pouvez appliquer ces mêmes principes sans avoir à devenir statisticien au préalable.

Nous répondons à certaines des questions les plus courantes sur la conception d'expériences afin de vous aider à démarrer.

Le test A/B est idéal pour comparer deux versions d'une seule variable (par exemple, deux titres pour un e-mail). La conception d'expérience, en revanche, vous permet de tester simultanément plusieurs variables (titre, image, CTA) et, surtout, leurs interactions, afin de découvrir la combinaison gagnante en beaucoup moins de temps.

En théorie, il n'y a pas de limites, mais en pratique, l'efficacité est essentielle. En utilisant des conceptions intelligentes telles que les factoriels fractionnés, vous pouvez analyser un grand nombre de facteurs (même 8 à 10 ou plus) avec un nombre d'expériences gérable. Les plateformes modernes permettent de gérer efficacement cette complexité.

Non, plus maintenant. Même si comprendre les principes de base aide, l'époque où il fallait un doctorat en statistiques pour appliquer la DOE est révolue.

Aujourd'hui, les plateformes basées sur l'IA, comme la nôtre, automatisent les analyses complexes et transforment les résultats en informations compréhensibles par tous. Cela fait de la conception d'expériences un outil accessible aux managers et aux analystes qui souhaitent prendre des décisions basées sur des données.

Êtes-vous prêt à transformer vos données en décisions stratégiques ? Grâce à notre plateforme, vous pouvez exploiter toute la puissance de la conception d'expériences sans en subir la complexité. Commencez votre essai gratuit →