Au cours des derniers mois, la communauté de l'intelligence artificielle a été traversée par un débat houleux déclenché par deux documents de recherche influents publiés par Apple. Le premier, illusion-of-thinking-the-debate-that-is-shaking-the-world-of-ai&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target="_blank" id="">"GSM-Symbolic" (octobre 2024), et le second, "L'illusion de la pensée" (juin 2025), remettent en question les prétendues capacités de raisonnement des grands modèles de langage, suscitant des réactions mitigées dans le secteur.

Comme nous l'avons déjà analysé dans notre précédent article intitulé « L'illusion du progrès : simuler l'intelligence artificielle générale sans l'atteindre », la question du raisonnement artificiel touche au cœur même de ce que nous considérons comme l'intelligence dans les machines.

Les chercheurs d'Apple ont effectué une analyse systématique des grands modèles de raisonnement (Large Reasoning Models - LRM ), c'est-à-dire des modèles qui génèrent des traces de raisonnement détaillées avant de fournir une réponse. Les résultats ont été surprenants et, pour beaucoup, alarmants.

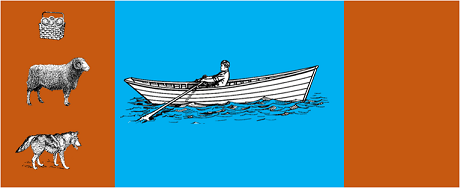

L'étude a soumis les modèles les plus avancés à des énigmes algorithmiques classiques telles que :

Les résultats ont montré que même de petites modifications dans la formulation du problème entraînent des variations significatives des performances, ce qui suggère une fragilité inquiétante dans le raisonnement. Comme l'a rapporté AppleInsider coverageles performances de tous les modèles diminuent lorsque seules les valeurs numériques des questions de référence GSM-Symbolic sont modifiées".

La réponse de la communauté de l'IA ne s'est pas fait attendre. Alex Lawsen d'Open Philanthropy, en collaboration avec Claude Opus d'Anthropic, a publié une réfutation détaillée intitulée L'illusion de la pensée".contestant les méthodologies et les conclusions de l'étude Apple.

Lorsque M. Lawsen a répété les tests avec d'autres méthodologies - en demandant aux modèles de générer des fonctions récursives au lieu d'énumérer tous les mouvements - les résultats ont été radicalement différents. Des modèles comme Claude, gemini et GPT ont correctement résolu les problèmes de la Tour de Hanoï avec 15 enregistrements, bien au-delà de la complexité pour laquelle Apple a rapporté zéro succès.

Gary Marcuscritique de longue date des capacités de raisonnement des LLM, a considéré les résultats d'Apple comme une confirmation de la thèse qu'il défend depuis 20 ans. Selon Gary Marcus, les LLM continuent de lutter contre le "changement de distribution" - la capacité à généraliser au-delà des données de formation - tout en restant "de bons résolveurs de problèmes qui ont déjà été résolus".

Le débat s'est également étendu à des communautés spécialisées telles que LocalLlama sur Redditoù des développeurs et des chercheurs débattent des implications pratiques des modèles à code source ouvert et de la mise en œuvre locale.

Ce débat n'est pas purement académique. Il a des implications directes pour :

Comme le soulignent plusieurs aperçus techniquesil est de plus en plus nécessaire d'adopter des approches hybrides qui combinent :

Exemple trivial: un assistant IA qui vous aide à tenir votre comptabilité. Le modèle linguistique comprend lorsque vous demandez "combien ai-je dépensé en voyages ce mois-ci ?" et extrait les paramètres pertinents (catégorie : voyages, période : ce mois-ci). Mais la requête SQL qui interroge la base de données, calcule la somme et vérifie les contraintes fiscales ? C'est le code déterministe qui s'en charge, et non le modèle neuronal.

Il n'a pas échappé aux observateurs que le document d'Apple a été publié peu avant la WWDC, ce qui soulève des questions sur les motivations stratégiques. Comme l'indique l'analyse de 9to5Macanalyse de 9to5Macle moment choisi pour la publication de l'article d'Apple - juste avant la WWDC - a fait froncer les sourcils. S'agissait-il d'une étape importante de la recherche ou d'un mouvement stratégique visant à repositionner Apple dans le paysage plus large de l'IA ?"

Le débat suscité par les documents d'Apple nous rappelle que nous n'en sommes qu'aux premiers stades de la compréhension de l'intelligence artificielle. Comme nous l'avons souligné dans notre article précédentla distinction entre simulation et raisonnement authentique reste l'un des défis les plus complexes de notre époque.

La véritable leçon n'est pas de savoir si les LLM peuvent ou non "raisonner" au sens humain du terme, mais plutôt comment nous pouvons construire des systèmes qui exploitent leurs forces tout en compensant leurs limites. Dans un monde où l'IA transforme déjà des secteurs entiers, la question n'est plus de savoir si ces outils sont "intelligents", mais comment les utiliser de manière efficace et responsable.

L'avenir de l'IA d'entreprise ne résidera probablement pas dans une seule approche révolutionnaire, mais dans l'orchestration intelligente de plusieurs technologies complémentaires. Et dans ce scénario, la capacité à évaluer de manière critique et honnête les capacités de nos outils devient elle-même un avantage concurrentiel.

Derniers développements (janvier 2026)

OpenAI lance o3 et o4-mini: Le 16 avril 2025, OpenAI a lancé publiquement o3 et o4-mini, les modèles de raisonnement les plus avancés de la série o. Ces modèles peuvent désormais utiliser des outils de manière proactive, en combinant recherche sur le Web, analyse de fichiers, raisonnement visuel et génération d'images. o3 a établi de nouveaux records sur des benchmarks tels que Codeforces, SWE-bench et MMMU, tandis que o4-mini optimise les performances et les coûts pour les tâches de raisonnement à haut volume. Les modèles démontrent leur capacité à « penser en images », en transformant visuellement le contenu pour une analyse plus approfondie.

DeepSeek-R1 bouleverse le secteur de l'IA: en janvier 2025, DeepSeek a lancé R1, un modèle de raisonnement open source qui a atteint des performances comparables à celles d'OpenAI o1 avec un coût de formation de seulement 6 millions de dollars (contre des centaines de millions pour les modèles occidentaux). DeepSeek-R1 démontre que les capacités de raisonnement peuvent être stimulées par un apprentissage par renforcement pur, sans avoir besoin de démonstrations humaines annotées. Le modèle est devenu l'application gratuite n° 1 sur l'App Store et Google Play dans des dizaines de pays. En janvier 2026, DeepSeek a publié un article de 60 pages qui révèle les secrets de la formation et admet candidement que des techniques telles que la recherche arborescente Monte Carlo (MCTS) n'ont pas fonctionné pour le raisonnement général.

Anthropic met à jour la « Constitution » de Claude: Le 22 janvier 2026, Anthropic a publié une nouvelle constitution de 23 000 mots pour Claude, passant d'une approche basée sur des règles à une approche basée sur la compréhension des principes éthiques. Ce document devient le premier cadre d'une grande entreprise d'IA à reconnaître officiellement la possibilité d'une conscience ou d'un statut moral de l'IA, affirmant qu'Anthropic se soucie du « bien-être psychologique, du sens de soi et du bien-être » de Claude.

Le débat s'intensifie: une étude réalisée en juillet 2025 a reproduit et affiné les benchmarks d'Apple, confirmant que les LRM présentent toujours des limites cognitives lorsque la complexité augmente modérément (environ 8 disques dans la tour de Hanoï). Les chercheurs ont démontré que cela ne dépend pas uniquement de contraintes de sortie, mais aussi de limites cognitives réelles, soulignant que le débat est loin d'être clos.

Notre équipe d'experts est à votre disposition pour des consultations personnalisées afin de vous éclairer sur la stratégie de votre organisation en matière d'IA et sur la mise en œuvre de solutions robustes.